Imaginați-vă că vă bate poliția la ușă pentru ca ați postat un „comentariu problematic” pe o rețea de socializare.

Imaginați-vă acum că un judecător va bagă la închisoare, scuzați, voiam să spunem la ospiciu, pentru că un program de calculator a considerat comentariul dumneavoastră „problematic”.

Nu vă mai imaginați, toate astea se întâmplă deja.

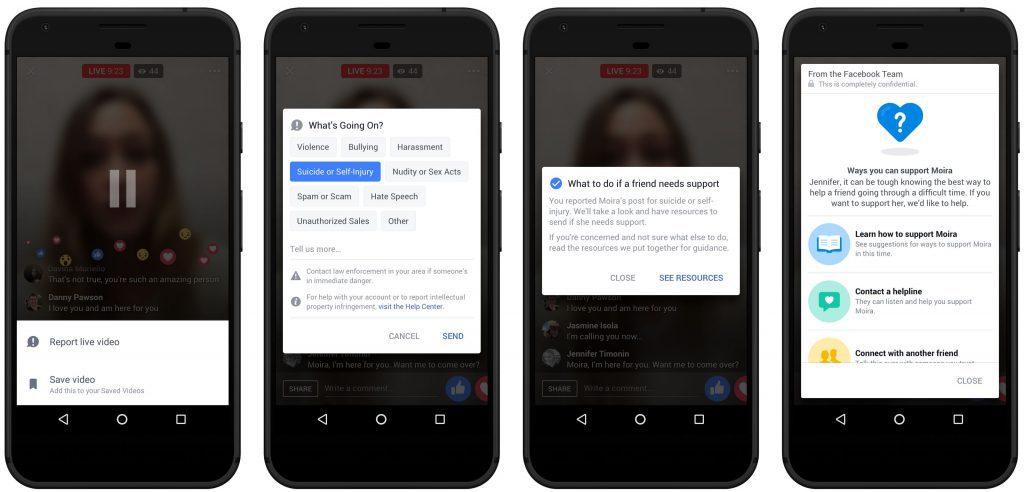

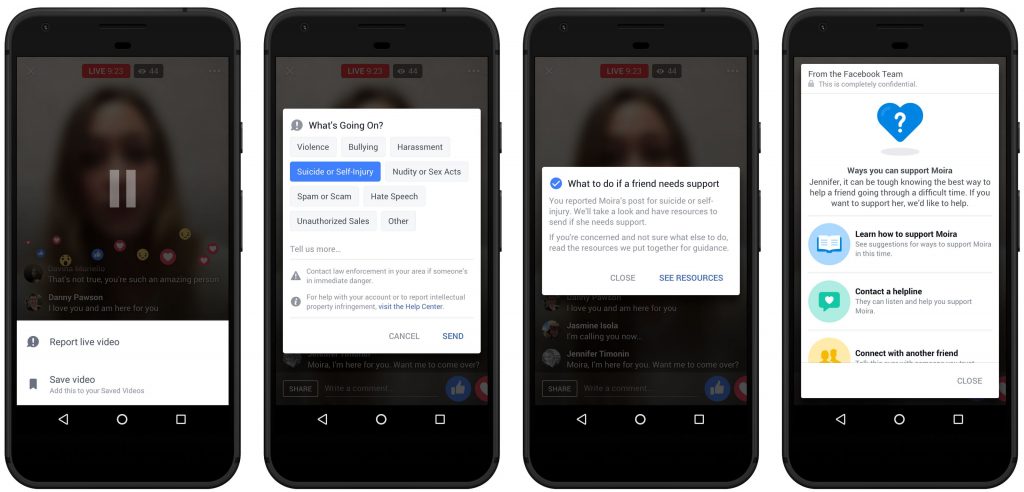

Un articol recent publicat de TechCrunch avertizează că algoritmii „Proactive Detection” folosiți de Facebook vor folosi șabloane de recunoaștere pentru apela imediat numărul de urgență. Programul va contacta autoritățile dacă va considera că un un comentator este susceptibil să comită suicid.

TechCrunch: „Facebook va folosi de asemenea inteligența artificială pentru a prioritiza comentariile urgente sau riscante așa că ele vor fi abordate mai repede de către moderatori, având la dispoziție si instrumentele pentru a detecta imediat limba vorbită de autorul comentariului și locația acestuia.”

O companie privată să decidă cine merge la închisoare? Ce-ar putea fi rău în asta?

Inteligența artificială a Facebook va contacta automat autoritățile

Facebook folosește șabloane de recunoaștere și moderatori pentru a contacta autoritățile.

Facebook utilizază „șabloane de recunoaștere pentru a detecta postări sau transmisii video în direct în care cineva ar putea să exprime tendința de suicid pentru a putea răspunde și avetiza mai repede numărul de urgență”

„Alocăm și mai mulți supervizori din cadrul echipei Community Operations pentru a revizui rapoarte de suicid sau de auto-vătămare.” (Facebook – sursa aici)

Facebook admite că a solicitat poliției peste O SUTĂ DE VERIFICĂRI privind starea unor persoane.

„Pe parcursul lunii trecute, am lucrat cu comentatorii în peste 100 de verificări ale stării persoanelor pe baza rapoartelor obținute datorită eforturilor noastre de detecție proactivă. Asta se adaugă la rapoartele pe care le primim de la membrii comunității Facebook.” (Sursa aici)

De ce poliția realizează verificări pentru Facebook? Oare departamentele de poliție sunt conduse de companii private?

Utilizatorii de rețele sociale media trebuie să-și facă griji nu doar că o inteligență artificală îi spionează, mai nou ei vor trebui să se îngrijească și de miile de membrii ai echipei Facebook „Community Operations”, gata să sune la poliție în orice moment.

„Echipa « Community Operations» este formată din mii de oameni de pe glob care studiază rapoartele despre conținutul postat pe Facebook… echipa noastră studiază postari, videoclipuri sau transmisiuni vedeo în direct. Asta ne asigură că alocăm resursele potrivite persoanelor aflate în dificultate și, acolo unde este cazul, să alertăm rapid autoritățile.” Sursa aici.

Să avem încredere că recunoașterea prin șabloane va determina corect cine să fie internat sau arestat?

Recunoașterea prin șabloane este o știință falsă

Un articol publicat de Forbes in 2016 folosea cuvinte precum „nonsens, pedant, închipuit sau oglinzi și fum” pentru a descrie recunoașterea prin șabloane și comportamentul uman.

„Algoritmii foarte stricți, chiar și determinați științific, fac mai mult rău decât bine. Fiecare persoanâ este diferită. Implicarea este un fenomen individual și unic. Nu suntem pictograme pe un ecran și nici nu respectăm fomule făcute din pictograme.” Sursa aici.

Dar Facebook vrea să salveze vieți. Nu mai contează că recunoaștere prin șabloane e o știință falsă. Corect?

Greșit.

Imaginați-vă că intr-un viitor nu foarte îndepărtat stați cu prietenii într-un bar și cineva întreabă ce mai știți pe Susan? Unul dintre prietenii voștri va răspunde că da și că e foarte trist că a publicat pe rețeaua de socializare un comentariu problematic care a determinat arestarea ei.

Acesta este viitorul nostru, dacă vom lăsa corporațiile să decidă pe cine ar trebui poliția să aresteze sau să interneze.

Folosirea inteligenței artificiale pentru a determina cine este internat sau încarcerat poate să cauzeze (și o va face) abuzuri.

Informații preluate și de pe massprivatei.blogspot.ro unde articolul a apărut inițial